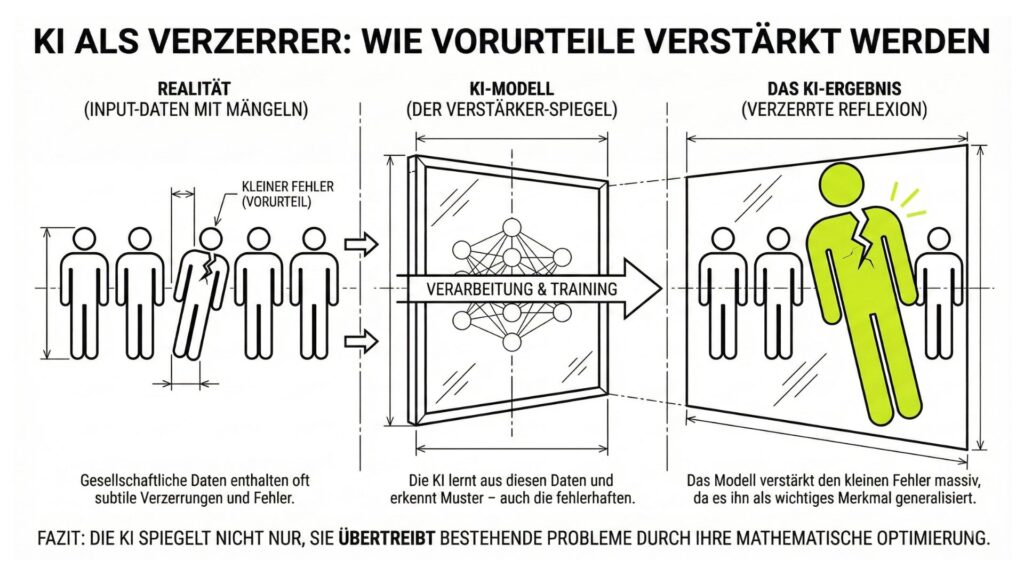

Warum Künstliche Intelligenz nicht objektiv ist, sondern unsere menschlichen Fehler spiegelt.

Kurz & bündig

Frage: Ist eine Computer-Entscheidung nicht viel objektiver als die eines Menschen? Antwort: Nein, das ist ein gefährlicher Irrtum. Da KI nur aus Daten lernt, die von Menschen stammen, übernimmt sie auch alle unsere Vorurteile. Wenn die Datenbasis schief ist, ist auch das Ergebnis schief („Bias“). Die KI wirkt objektiv, aber sie zementiert oft nur alte Ungerechtigkeiten.Inhaltsverzeichnis

Der Mythos von der neutralen Maschine

Wir neigen dazu, Computern mehr zu vertrauen als Menschen. Wenn der Rechner sagt: „Kredit abgelehnt“ oder „Bewerber nicht geeignet“, akzeptieren wir das oft als nüchternes mathematisches Faktum. Ein Computer hat schließlich keine schlechte Laune und mag niemanden lieber als andere, oder? Doch. KI hat zwar keine Gefühle, aber sie hat „Lehrmeister“ – und das sind wir. Wie wir im letzten Kapitel (Training) gelernt haben, braucht KI Millionen von Beispielen. Und diese Beispiele stammen aus unserer echten, unperfekten Welt.Wie Vorurteile in die Maschine kommen (Bias)

Diesen Effekt nennt man „Bias“ (engl. für Verzerrung oder Voreingenommenheit). Er entsteht meistens völlig unabsichtlich, einfach durch die Auswahl der Trainingsdaten.Beispiel: Die „männliche“ Chefetage

Stell dir vor, eine KI soll lernen, gute Führungskräfte zu erkennen. Man füttert sie mit den Lebensläufen erfolgreicher Manager der letzten 30 Jahre.

Das Problem: In den letzten 30 Jahren waren 90% der Chefs Männer.

Die KI lernt: „Mann sein“ ist ein statistisches Merkmal für Erfolg.

Wenn nun die Bewerbung einer Frau kommt, sortiert die KI sie aus. Nicht aus Bosheit, sondern weil sie stur ihr gelerntes Muster anwendet. Sie wiederholt die Vergangenheit, statt die Zukunft zu gestalten.

Garbage In, Garbage Out (Müll rein, Müll raus)

In der Informatik gibt es einen alten Merksatz: „Garbage In, Garbage Out“. Die Qualität der Antwort hängt zu 100% von der Qualität der Eingabe ab. Das betrifft nicht nur Geschlechterfragen, sondern ganz praktische Dinge im Alltag:- 🌍 Gesichtserkennung: Viele KI-Systeme wurden hauptsächlich mit Fotos von weißen Männern trainiert. Die Folge: Bei Frauen oder Menschen mit dunkler Hautfarbe funktionieren sie viel schlechter oder machen peinliche Fehler.

- 🏥 Medizin: Eine KI zur Hautkrebs-Erkennung lernte fast nur mit Bildern heller Haut. Bei dunkler Haut übersieht sie den Krebs oft, weil sie dieses „Muster“ nie gesehen hat.

- 🗣️ Spracherkennung: Wer Hochdeutsch spricht, wird von Siri & Co. gut verstanden. Wer einen starken Dialekt hat, wird oft ignoriert – weil die KI nicht genug „Bayrisch“ oder „Sächsisch“ geübt hat.

Warum „Datenbereinigung“ so schwer ist

Man könnte nun sagen: „Dann löscht doch einfach das Geschlecht aus den Daten!“ Doch so einfach ist es nicht. KI findet Korrelationen (Zusammenhänge), wo wir keine sehen.Der versteckte Zusammenhang

Eine US-Versicherung nutzte eine KI, um Risikopatienten zu finden. Man verbot der KI ausdrücklich, die Hautfarbe zu nutzen.

Trotzdem benachteiligte sie schwarze Patienten massiv.

Warum? Die KI nutzte stattdessen die Postleitzahl. Da in den USA Wohngebiete oft stark nach Bevölkerungsgruppen getrennt sind, wurde die Adresse zum „Ersatz-Merkmal“ für die Hautfarbe. Die KI fand das Vorurteil durch die Hintertür wieder.

Fazit: Vertrauen ist gut, Kontrolle ist besser

Was bedeutet das für dich? Wenn du hörst „Eine KI hat das berechnet“, sei skeptisch. Frage dich:- Wer hat die KI trainiert?

- Mit welchen Daten?

- Fehlen vielleicht Perspektiven?

Glossar: Fachbegriffe zu Daten & Ethik

| Begriff | Erklärung |

|---|---|

| Bias (sprich: „Bai-es“) | Eine systematische Verzerrung in den Daten, die zu fairen Ergebnissen führt (z.B. Vorurteile gegen Gruppen). |

| Trainingsdaten | Das „Futter“ für die KI. Sind sie einseitig, wird auch die KI einseitig. |

| Diskriminierung durch Algorithmen | Wenn Computer bestimmte Menschengruppen benachteiligen, nicht aus böser Absicht, sondern wegen fehlerhafter Daten. |

| Korrelation | Ein statistischer Zusammenhang (z.B. „Wenn es regnet, wird der Rasen nass“). KI sucht nur danach, oft ohne die Ursache zu verstehen. |

Weiterführende Informationen

Interne Links

- vorheriges Kapitel – Der Blick unter die Haube: Neuronale Netze und Deep Learning

- nächstes Kaptiel – Wie Computer Sprache „verstehen“ (ChatGPT & Co.)