Von autonomen Autos bis zu militärischen Drohnen: Warum die Maschine niemals die letzte Entscheidung treffen darf.

Kurz & bündig

Frage: Wenn eine KI einen Fehler macht, wer kommt dafür ins Gefängnis? Antwort: Niemals die KI selbst. Sie ist eine Sache, keine Person. Die Verantwortung liegt immer beim Menschen: Entweder beim Hersteller (wenn die Software fehlerhaft war) oder beim Anwender (wenn er die Technik falsch genutzt hat). Das Prinzip lautet: Es muss immer einen Menschen geben, der den „Stecker ziehen“ kann.Inhaltsverzeichnis

Der Autopilot und das Dilemma der Verantwortung

Stell dir vor, du sitzt in einem selbstfahrenden Auto. Du liest Zeitung. Plötzlich springt ein Kind auf die Straße. Das Auto weicht aus – und rammt dabei ein parkendes Fahrzeug. Wer ist schuld? Du, weil du nicht aufgepasst hast? Oder der Autohersteller, weil die Software so programmiert war? Dies ist keine Science-Fiction mehr, sondern eine reale juristische Frage. Die Grundregel lautet derzeit: Der Mensch bleibt der Pilot. Auch Assistenzsysteme entbinden uns nicht von der Aufsichtspflicht. Wir dürfen das Steuer loslassen, aber nicht die Verantwortung.Das Problem der „Blackbox“ (Intransparenz)

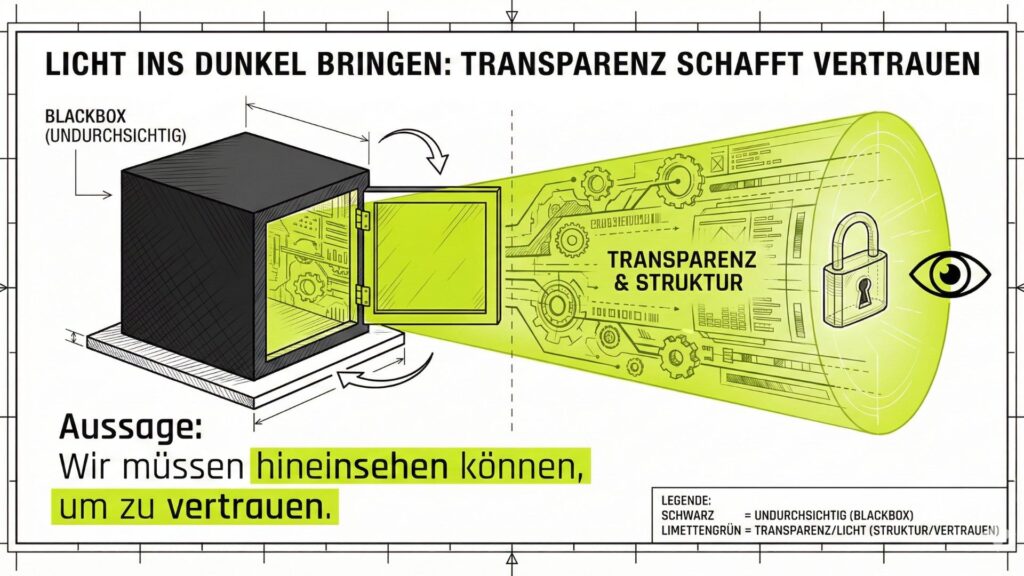

Warum tun wir uns so schwer, der KI zu vertrauen? Weil sie oft eine Blackbox ist. Das bedeutet: Wir sehen, was reingeht (Daten) und was rauskommt (Entscheidung), aber wir verstehen nicht, was dazwischen passiert.Beispiel: Der abgelehne Kredit

Eine Bank-KI lehnt deinen Kreditantrag ab.

Der Bankberater sagt: „Tut mir leid, der Computer sagt Nein. Ich weiß auch nicht warum.“

Das ist ethisch inakzeptabel. Wir haben ein Recht auf Erklärung. Vielleicht hat die KI dich nur abgelehnt, weil Menschen in deiner Postleitzahl statistisch öfter ihre Rechnungen nicht zahlen (Sippenhaft durch Daten).

Die Forderung der Ethik: Keine Entscheidung über Menschen ohne Erklärung („Explainable AI“).

Die rote Linie: KI als Waffe

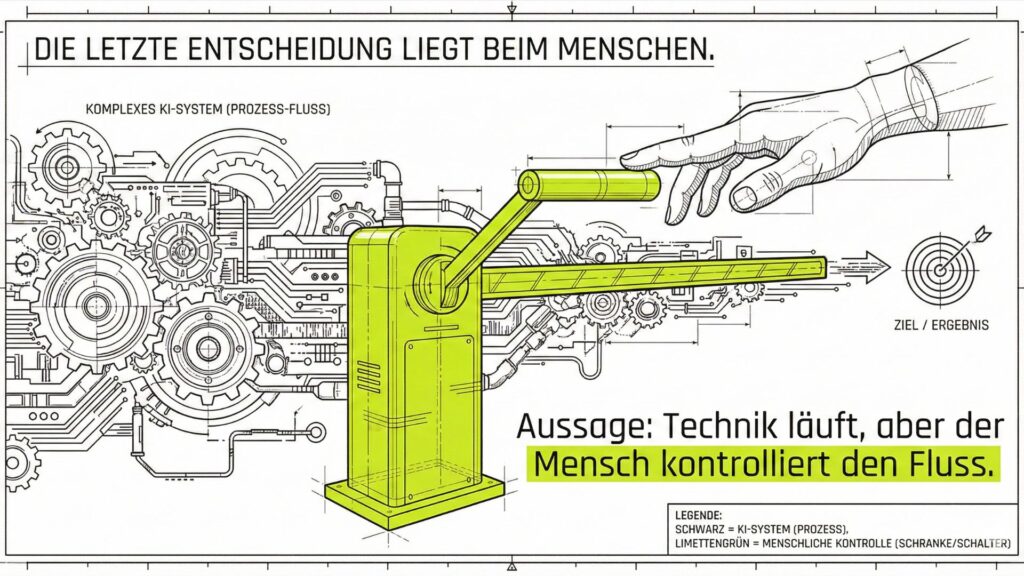

Am brisantesten wird die Ethik, wenn es um Leben und Tod geht. Militärs weltweit nutzen KI für Aufklärung und Zielerfassung. Doch hier ziehen Ethiker eine klare rote Linie: Autonome Waffensysteme (Killerroboter). Eine Maschine darf niemals selbstständig entscheiden, einen Menschen zu töten. Sie hat kein Gewissen, kein Mitgefühl und versteht den Wert eines Lebens nicht. Sie führt nur einen Befehl aus „Ziel erkannt -> Feuern“. Deshalb gilt das Prinzip „Human in the Loop“ (Der Mensch in der Schleife): Die KI darf Ziele suchen, aber der finale Knopfdruck muss von einem Menschen kommen. Er trägt die moralische Last, nicht der Chip.

Drei goldene Regeln für den Umgang mit KI

Damit wir die Kontrolle behalten, fordern Experten drei Grundsätze:- ⚖️ Haftung: Es muss immer klar sein, welche juristische Person (Firma oder Mensch) für Schäden geradesteht.

- 🔍 Transparenz: Es muss gekennzeichnet sein, wenn wir mit einer KI sprechen (Kennzeichnungspflicht für Bots).

- 🛑 Not-Aus: Jedes autonome System muss vom Menschen jederzeit gestoppt werden können.

Fazit: Wir sind die Eltern der Technik

Wir dürfen uns nicht herausreden mit „Die KI hat das gemacht“. Wir haben die KI gebaut. Wir haben sie trainiert. Wir lassen sie laufen. Also tragen wir auch die Verantwortung für das, was sie tut.Glossar: Ethik-Begriffe

| Begriff | Erklärung |

|---|---|

| Human in the Loop | Das Prinzip, dass bei kritischen Entscheidungen (z.B. Waffeneinsatz, Medizin) immer ein Mensch die letzte Bestätigung geben muss. |

| Blackbox | Ein KI-System, dessen Entscheidungswege so komplex sind, dass man sie von außen nicht mehr nachvollziehen kann. |

| Explainable AI (Erklärbare KI) | Der Versuch, KI so zu bauen, dass sie begründen kann, warum sie so entschieden hat („Ich habe abgelehnt, weil das Einkommen zu niedrig war“). |

| Autonome Systeme | Maschinen, die Aufgaben ohne menschliches Eingreifen erledigen (z.B. Staubsauger-Roboter oder Marschflugkörper). |

Weiterführende Informationen

Interne Links

- vorheriges Kapitel – Die Kunst, mit der KI zu sprechen (Prompting Grundlagen)

- nächstes Kapitel – KI & die Gesellschaft: Gewinner und Verlierer (Arbeit & Generationen)